Les données textuelles, sonores et vidéos sur internet sont une ressource vitale pour les moteurs d'intelligence artificielle. ChatGPT, Gemini et leurs concurrents ont besoin de récupérer d'immenses volumes d'informations pour gagner en précision. Des besoins qui se heurtent à des questions de droits d'accès et de disponibilité de ces ressources.

Vers la fin de 2021, OpenAI, le créateur de ChatGPT, s'est retrouvé face à un problème d'approvisionnement en données, raconte le New York Times dans un article sur la quête éperdue de Microsoft, Google, Facebook, mais aussi Apple pour trouver, avaler et traiter toujours plus d'informations.

IA : Apple aurait passé un contrat avec Shutterstock pour utiliser sa banque d’images

Ces systèmes d'intelligence artificielle construisent leurs réponses sur la foi de bases de connaissance. Plus elles sont importantes, d'origines variées et de qualité élevée, plus ces réponses gagnent en précision. OpenAI a alors constaté qu'il avait déjà avalé tout ce qu'il était possible de trouver comme contenus textuels fiables en langue anglaise.

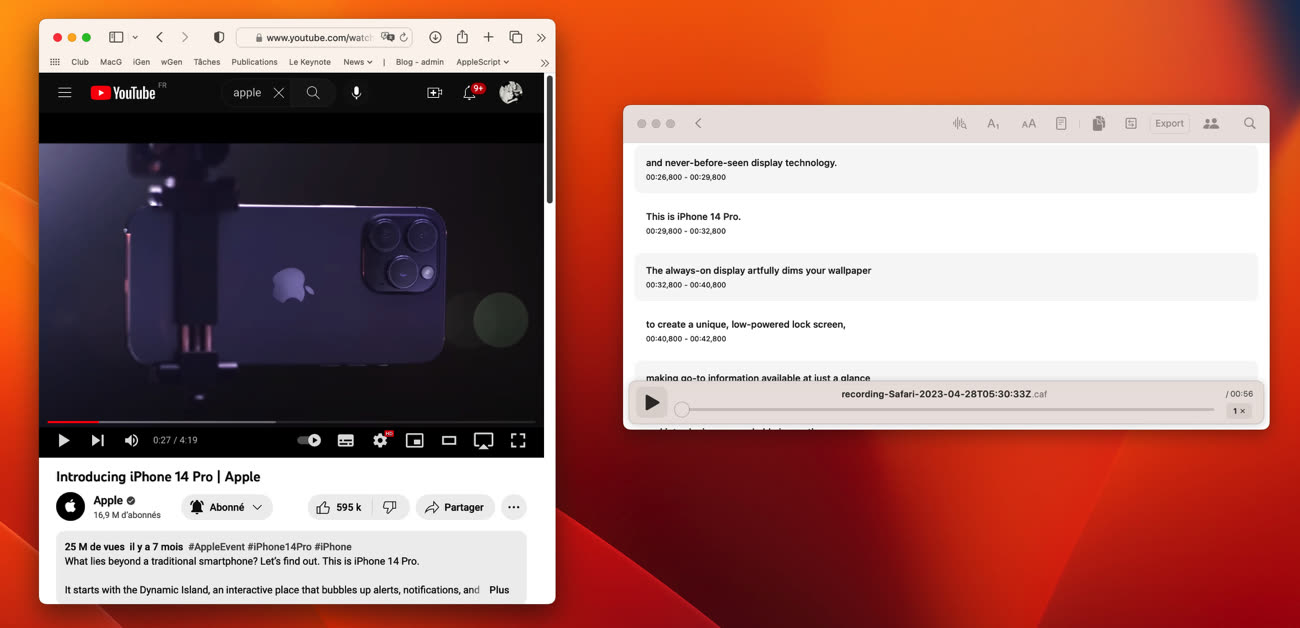

Pour continuer d'entrainer la version suivante de son moteur, GPT-4, il lui en fallait (beaucoup) plus. Un an plus tard, OpenAI lançait Whisper, un outil de transcription de pistes audio en texte. OpenAI s'en servit pour traiter notamment les vidéos de YouTube et faire grossir son index d'une nouvelle masse de données.

Transcription audio : énorme amélioration de performances pour Whisper sur Mac

Plus d'un million d'heures de vidéos YouTube furent analysées par Whisper, d'après les sources du New York Times et il fut utilisé également sur des podcasts et des livres audio. Les employés d'OpenAI savaient qu'ils s'aventuraient dans une zone grise en matière de droits d'utilisation. L'exploitation de vidéos YouTube par ce biais peut être considérée comme illégale, mais il y a une part laissée à l'interprétation de ces conditions d'utilisation.

Officiellement, Google a déclaré n'avoir eu aucune connaissance des pratiques d'OpenAI, mais d'après les contacts du quotidien, il était parfaitement au fait de cette moisson réalisée par OpenAI. Google ne s'en est pas ému davantage, car lui-même avait puisé dans ce contenu pour entrainer son moteur. En sermonnant publiquement OpenAI il risquait de se retrouver en porte-à-faux face à ses créateurs sur YouTube.

Pour éviter toute mésaventure, Google a ensuite revu les conditions d'utilisation des contenus publics produits par ses services Google Docs, Sheet et Slides afin d'autoriser leur exploitation pour l'entrainement de moteurs d'IA.

Lancé dans la même course initiée par OpenAI et son partenaire Microsoft, Meta s'est rapidement retrouvé au pied du même mur : plus assez de données. Plusieurs pistes furent discutées, comme d'acheter Simon & Schuster, l'un des plus gros éditeurs au monde afin d'avoir accès à ses livres, lesquels contiennent des données considérées comme fiables.

D'autres chez Meta proposèrent de payer jusqu'à 10 $ par livre pour en obtenir tous les droits. Certains expliquèrent qu'ils avaient déjà résumé des livres, des essais et d'autres travaux trouvés sur le web, sans autorisation et qu'il était possible de continuer à en aspirer davantage, quand bien même il y avait des risques de procès (le New York Times a attaqué OpenAI et Microsoft pour cette même raison).

Un avocat de Meta fit valoir que cela posait un problème éthique, mais sa remarque fut accueillie par un silence des autres participants. Négocier des droits implique de longues discussions et ces protagonistes de l'IA courent un marathon à la vitesse d'un sprint. Lors de ces échanges, il fut aussi expliqué que des contractuels en Afrique avaient été payés pour compiler des résumés de contenus de fiction et de non-fiction, dont certains étaient protégés par des droits d'auteur. Ces moissonneuses ratissent large et ne font pas de tri entre ce qui peut être pris et ce qui ne doit pas l'être.

Meta n'est pas en manque de contenus avec ses réseaux sociaux, toutefois cette masse n'est pas nécessairement d'une grande qualité ou utilité. Au bout du compte, le problème numéro un reste le manque de données utilisables et suffisamment qualitatives pour faire progresser ces moteurs. On parle actuellement de l'utilisation de volume équivalent à plusieurs centaines de milliards de mots.

Mais pour franchir un nouveau cap dans l'amélioration de ces intelligences artificielles, il faudrait faire un bond en quantité de données pertinentes indexées : l'offre est dépassée par la demande.

Une piste étudiée est de faire en sorte que ces IA produisent de nouvelles données à partir de celles qui sont déjà en leur possession. Des données dites "synthétiques". Avec le risque que ces IA finissent par tourner en circuit fermé et ne fassent qu'accentuer des biais ou des erreurs qu'elles font déjà avec les informations dont elles disposent.

Source :