Il y a quelques jours se tenait MobileHCI'09, la conférence internationale de référence sur les interactions sur mobile. Cet événement, qui se déroulait cette année à Bonn en Allemagne, rassemble depuis 11 ans des chercheurs du monde entier autour du problème des Interactions homme-machine (IHM, HCI en anglais) pour mobiles. Des chercheurs de Nokia, Microsoft Research, Samsung, HP, HTC, Orange Labs, RIM, Vodafone, IBM, et bien sûr Apple (pour ne citer que les plus connus) ont ainsi fait le déplacement, sans compter les très nombreux universitaires.

Première constat en arrivant sur les lieux : il y a des pommes partout. La communauté de chercheurs spécialisés dans les IHM est en majorité pro-Apple, et ça se voit. Les Mac sont omniprésents, les iPhone sont dans presque toutes les mains. Plusieurs présentations se sont même terminées par un "one more thing...", à chaque fois salué par des rires ou des applaudissements. À noter que les eeePC et autres netbooks et ultra-portables étaient eux aussi assez bien représentés.

La conférence a été ouverte par Jun Rekimoto (Sony Computer Science Labs, Tokyo), véritable célébrité dans le domaine des IHM, principalement connu pour l'invention du Pick-and-Drop (une sorte de glisser-déposer entre deux ordinateurs) et pour ses travaux sur les surfaces augmentées. Ont suivi des démonstrations, des présentations d'articles, de posters, etc.

Bien que de nombreux sujets aient été abordés durant la conférence, l'accent a été mis sur l'utilisation des dispositifs mobiles en situation de déplacement : en marchant, en conduisant, etc. Il s'agit d'un aspect négligé par Apple avec son iPhone : l'écran tactile ne fournit pas de retour d'information kinesthésique à l'utilisateur, qui ne peut donc pas l'utiliser sans regarder l'écran ou sans focaliser toute son attention sur l'écran. À cet effet, Apple a récemment introduit la reconnaissance vocale dans iPhone OS 3, mais cette fonctionnalité est difficilement utilisable dans un environnement bruité.

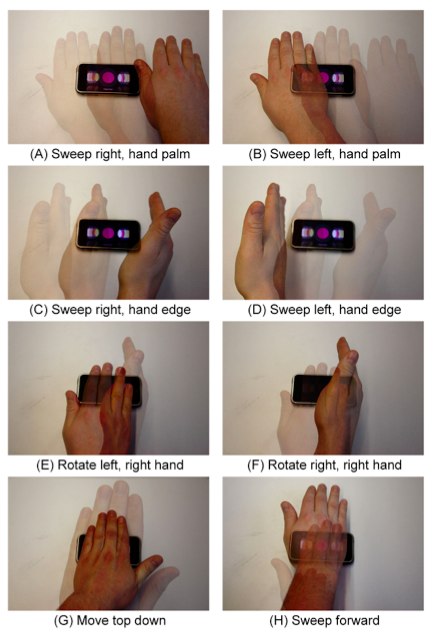

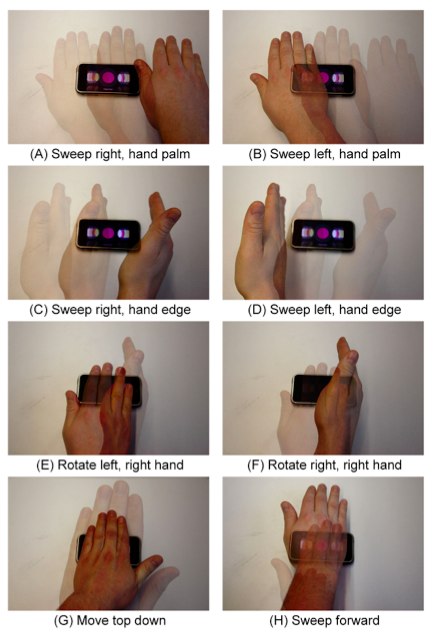

Ensuite, en situation de mobilité, l'utilisateur aura tendance à n'utiliser qu'une seule main pour interagir avec son appareil mobile. Là encore, le multi-touch d'Apple nécessite les deux mains. Les solutions proposées s'articulent principalement autour de l'interaction par gestes, du dessin de marques sur l'écran, ou encore de l'interaction sur les zones périphériques de l'écran (bords, face arrière, voire même à quelques centimètres du dispositif). Rekimoto a par exemple présenté un système permettant de zoomer avec un seul doigt en utilisant des informations sur la pression. HoverFlow permet quant à lui d'utiliser Cover Flow d'un geste de la main à quelques centimètres au dessus de l'iPhone, grâce à des capteurs infrarouges.

HoverFlow

D'autres systèmes intéressants ont été proposés, notamment en rapport avec les tags NFC, qui permettent l'échange d'information sans fil entre plusieurs appareils très proches. En touchant avec son téléphone une photo affichée sur l'écran du PC, on la télécharge automatiquement dans le téléphone. Il est prévu que l'intégration de tags NFC dans les téléphones ne coûte qu'un dollar d'ici trois ans.

On choisit l'image, on la touche et elle est transférée sur le mobile

Une autre voie qui semble particulièrement étudiée concerne les pico-projecteurs, qui permettront de projeter une large surface d'interaction sur un mur par exemple. De nombreux articles cherchent à améliorer la navigation dans des cartes (pour la navigation à pied, en voiture, ou même en vélo !). Enfin, des articles se consacrent à l'amélioration de la saisie de texte (souvent pour le chinois) sur dispositifs mobiles.

D'une manière générale, une forte tendance dans le domaine des mobiles réside dans la découverte automatique du contexte d'interaction (plateforme, environnement, utilisateur). En ayant connaissance de ce contexte, les interfaces pourront s'adapter automatiquement et les applications pourront proposer des informations plus pertinentes à l'utilisateur. Un système de profils intelligents a par exemple été présenté afin d'éviter d'être dérangé par son téléphone. Un tel système serait pertinent sur iPhone, avec lequel les utilisateurs sont de plus en plus dérangés par les notifications (appels, SMS, emails, applications diverses, messageries instantanées, etc.).

Attendue au tournant par bon nombre d'utilisateurs iPhone, la réalité augmentée sur mobiles n'a pas vraiment été mise en avant lors de cette conférence (voir les articles et vidéos sur ce sujet sur iGeneration). Surprenant alors qu'elle fait pourtant l'objet de nombreuses recherches depuis plus de 15 ans.

En conclusion, cette conférence a permis d'avoir une vue d'ensemble des travaux de recherche actuels dans le domaine des interactions sur dispositifs mobiles. On retiendra que la prise en compte de la mobilité et de l'environnement de l'utilisateur est privilégiée. Bien que l'iPhone soit unanimement reconnu comme une nouvelle génération d'expérience utilisateur et d'utilisabilité dans la téléphonie mobile, il n'est pas exempt de lacunes. Ces travaux de recherche peuvent donc donner des idées sur les futures fonctionnalités de l'iPhone et des appareils mobiles en général.

Compte rendu : Jérémie Francone, doctorant

Première constat en arrivant sur les lieux : il y a des pommes partout. La communauté de chercheurs spécialisés dans les IHM est en majorité pro-Apple, et ça se voit. Les Mac sont omniprésents, les iPhone sont dans presque toutes les mains. Plusieurs présentations se sont même terminées par un "one more thing...", à chaque fois salué par des rires ou des applaudissements. À noter que les eeePC et autres netbooks et ultra-portables étaient eux aussi assez bien représentés.

La conférence a été ouverte par Jun Rekimoto (Sony Computer Science Labs, Tokyo), véritable célébrité dans le domaine des IHM, principalement connu pour l'invention du Pick-and-Drop (une sorte de glisser-déposer entre deux ordinateurs) et pour ses travaux sur les surfaces augmentées. Ont suivi des démonstrations, des présentations d'articles, de posters, etc.

Bien que de nombreux sujets aient été abordés durant la conférence, l'accent a été mis sur l'utilisation des dispositifs mobiles en situation de déplacement : en marchant, en conduisant, etc. Il s'agit d'un aspect négligé par Apple avec son iPhone : l'écran tactile ne fournit pas de retour d'information kinesthésique à l'utilisateur, qui ne peut donc pas l'utiliser sans regarder l'écran ou sans focaliser toute son attention sur l'écran. À cet effet, Apple a récemment introduit la reconnaissance vocale dans iPhone OS 3, mais cette fonctionnalité est difficilement utilisable dans un environnement bruité.

Ensuite, en situation de mobilité, l'utilisateur aura tendance à n'utiliser qu'une seule main pour interagir avec son appareil mobile. Là encore, le multi-touch d'Apple nécessite les deux mains. Les solutions proposées s'articulent principalement autour de l'interaction par gestes, du dessin de marques sur l'écran, ou encore de l'interaction sur les zones périphériques de l'écran (bords, face arrière, voire même à quelques centimètres du dispositif). Rekimoto a par exemple présenté un système permettant de zoomer avec un seul doigt en utilisant des informations sur la pression. HoverFlow permet quant à lui d'utiliser Cover Flow d'un geste de la main à quelques centimètres au dessus de l'iPhone, grâce à des capteurs infrarouges.

HoverFlow

D'autres systèmes intéressants ont été proposés, notamment en rapport avec les tags NFC, qui permettent l'échange d'information sans fil entre plusieurs appareils très proches. En touchant avec son téléphone une photo affichée sur l'écran du PC, on la télécharge automatiquement dans le téléphone. Il est prévu que l'intégration de tags NFC dans les téléphones ne coûte qu'un dollar d'ici trois ans.

On choisit l'image, on la touche et elle est transférée sur le mobile

Une autre voie qui semble particulièrement étudiée concerne les pico-projecteurs, qui permettront de projeter une large surface d'interaction sur un mur par exemple. De nombreux articles cherchent à améliorer la navigation dans des cartes (pour la navigation à pied, en voiture, ou même en vélo !). Enfin, des articles se consacrent à l'amélioration de la saisie de texte (souvent pour le chinois) sur dispositifs mobiles.

D'une manière générale, une forte tendance dans le domaine des mobiles réside dans la découverte automatique du contexte d'interaction (plateforme, environnement, utilisateur). En ayant connaissance de ce contexte, les interfaces pourront s'adapter automatiquement et les applications pourront proposer des informations plus pertinentes à l'utilisateur. Un système de profils intelligents a par exemple été présenté afin d'éviter d'être dérangé par son téléphone. Un tel système serait pertinent sur iPhone, avec lequel les utilisateurs sont de plus en plus dérangés par les notifications (appels, SMS, emails, applications diverses, messageries instantanées, etc.).

Attendue au tournant par bon nombre d'utilisateurs iPhone, la réalité augmentée sur mobiles n'a pas vraiment été mise en avant lors de cette conférence (voir les articles et vidéos sur ce sujet sur iGeneration). Surprenant alors qu'elle fait pourtant l'objet de nombreuses recherches depuis plus de 15 ans.

En conclusion, cette conférence a permis d'avoir une vue d'ensemble des travaux de recherche actuels dans le domaine des interactions sur dispositifs mobiles. On retiendra que la prise en compte de la mobilité et de l'environnement de l'utilisateur est privilégiée. Bien que l'iPhone soit unanimement reconnu comme une nouvelle génération d'expérience utilisateur et d'utilisabilité dans la téléphonie mobile, il n'est pas exempt de lacunes. Ces travaux de recherche peuvent donc donner des idées sur les futures fonctionnalités de l'iPhone et des appareils mobiles en général.

Compte rendu : Jérémie Francone, doctorant