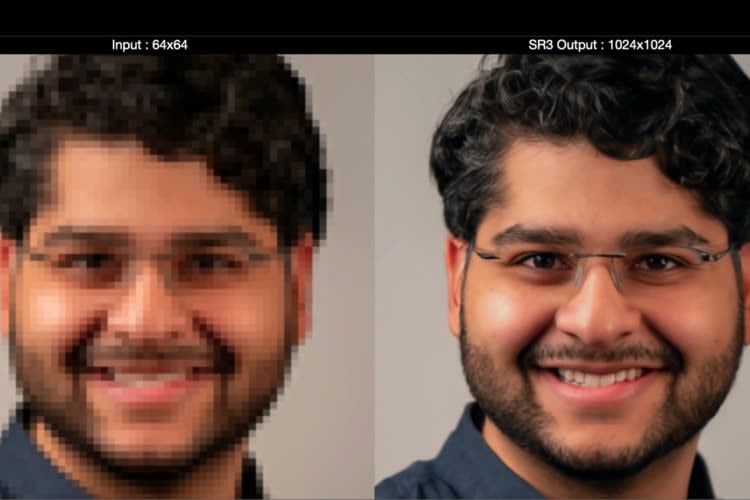

Vous connaissez peut-être thispersondoesnotexist.com, un site qui génère de faux selfies en se basant sur une intelligence artificielle de NVIDIA. Google travaille sur un concept similaire, mais beaucoup plus poussé baptisé Imagen. Son fonctionnement est simple : on entre une description de quelques mots, et l'IA se charge de vous concocter une image. L'entreprise a diffusé quelques exemples dans un billet de blog, et le résultat est bluffant. Jugez par vous-même :

Google n'est pas le premier sur ce segment : il existe déjà le logiciel DALL-E, dont une deuxième version est sortie le mois dernier et développée par OpenAI. Selon la firme de Mountain View, son outil est plus puissant. Elle s'est amusée à comparer ses résultats avec ceux de DALL-E, et son étude montre que les évaluateurs humains préfèrent nettement Imagen aux autres méthodes.

Si ces résultats sont impressionnants, il faut toutefois nuancer : les équipes ont sans doute choisi les meilleurs résultats et omis de relayer les images floues ou à côté de la plaque. DALL-E par exemple a du mal avec les négations (« un bol de fruits sans pommes »), les visages ou encore avec les textes. Google propose sur son site une petite démo, qui permet de jouer avec une version limitée de l'IA avec seulement quelques mots utilisables.

Il faut dire que les résultats parfois impressionnants obtenus grâce à cette IA n'incitent pas à laisser son code open source à l'heure où les fake-news se partagent à tour de bras. « Les risques potentiels d'utilisation abusive soulèvent des inquiétudes quant à l'ouverture responsable du code et des démos », précisent les équipes de Google.

De plus, les chercheurs expliquent avoir nourri leur algorithme à l'aide de très nombreuses données non triées venant du web. Autrement dit, ils ingèrent à peu près n'importe quoi, que ce soit de la pornographie ou des contenus haineux. « Ces ensembles de données ont tendance à refléter des stéréotypes sociaux, des points de vue oppressifs et des associations désobligeantes, ou autrement nuisibles, à des groupes d'identité marginalisés », précise le texte.

De plus, l'IA aurait un biais général en faveur de la génération d'images de personnes au teint plus clair ainsi qu'une « tendance à aligner les images représentant différentes professions sur les stéréotypes de genre occidentaux ». Les concurrents d'Imagen ont le même soucis : DALL-E a tendance à représenter le personnel de bord d'un avion comme des femmes, et les PDG comme des hommes.

Google précise également que son IA présente de sérieuses limitations lors de la génération d'images représentant des personnes. Tout cela pousse l'entreprise à conclure que son produit « n'est pas adapté à une utilisation publique sans mettre en place de garde-fous supplémentaires ».

Source :