Appuyez sur la petite baguette magique, et Pixelmator Photo embellit automatiquement votre image. De la magie ? Non, du machine learning, comme l’indiquent les initiales ML à côté de la baguette.

Grâce à leur moteur neuronal dédié, les puces Apple A11 et A12 des terminaux iOS sont capables d’effectuer des centaines de milliards d’opérations d’apprentissage automatique par seconde, ce qui rend le coup de baguette magique quasi instantané. Ce n’est toutefois que le bout de la chaîne.

On ne s’en rend pas compte quand on utilise Pixelmator Photo ou toute autre app exploitant des techniques de machine learning, mais l’éditeur a dû préparer son tour.

On parle, en intelligence artificielle, d’une phase d’entraînement. Dans le cas de Pixelmator Photo, 20 millions de photos ont été analysées pour que l’app « apprenne » à modifier correctement les vôtres. Un volume énorme qui implique un matériel adapté. C’était le thème de la table ronde « le hardware de l’IA » qui s’est tenue le 11 avril, lors du salon SIDO à Lyon.

Plus doués que les CPU pour les traitements parallèles, les GPU ont pris une place primordiale dans les procédures d’entraînement, pose en introduction Serge Palaric, VP Embedded EMEA chez Nvidia. Le spécialiste des GPU propose depuis plusieurs années tout un éventail de solutions et de produits dédiés à l’intelligence artificielle, de la carte graphique indépendante jusqu’à l’utilisation directe de ses centres de données.

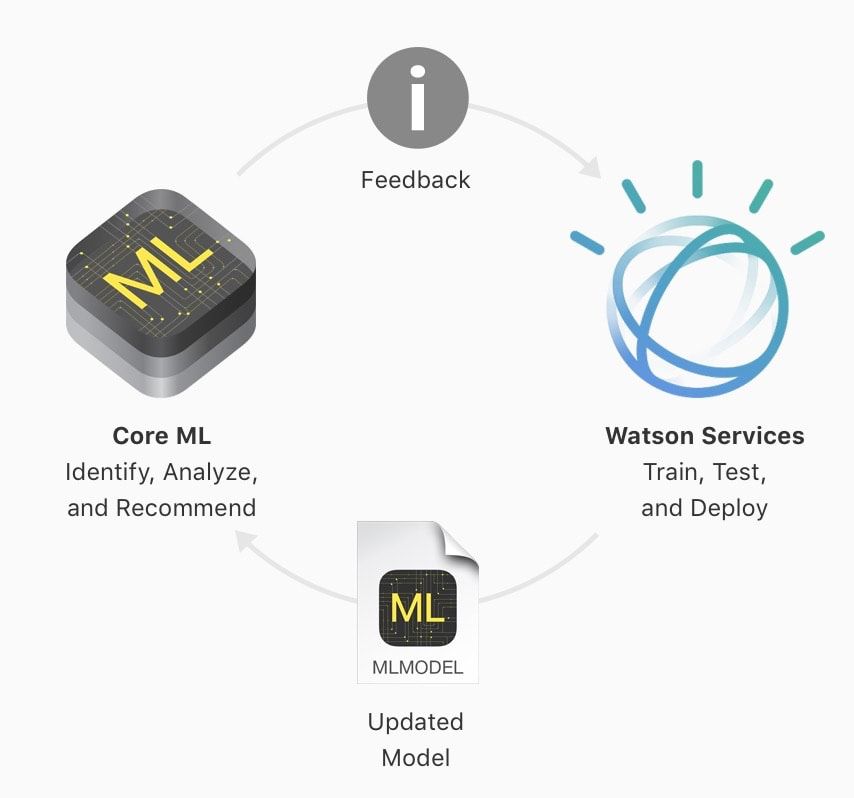

C’est également le cas d’IBM, qui a noué un partenariat avec Apple l’année dernière. Les développeurs iOS peuvent faire appel à la plateforme Watson pour entraîner leurs algorithmes avec de nombreuses données et ensuite les intégrer à leur application grâce au framework Core ML d’Apple.

« Chez IBM, les data centers ne sont pas uniformes », indique Xavier Vasques, IBM Systems Technology Center Director. Il est nécessaire de diversifier l’équipement des centres de données pour optimiser les traitements, car chaque projet a ses spécificités. « Le temps passé à entraîner un modèle, c’est du temps qui ralentit l’innovation. [L’entraînement] peut durer des semaines, voire des mois », fait-il valoir.

Dans ce contexte, « il faut penser le hardware différemment, trouver de nouvelles approches pour s’affranchir des goulots d’étranglement. » Un exemple à suivre, c’est le cerveau humain, un cerveau qui « fait rêver » IBM et les autres experts. Plusieurs entreprises planchent actuellement sur des puces neuromorphiques, c’est-à-dire des puces qui miment le fonctionnement du cerveau.

« Grâce à ses circuits neurone-synapse, notre cerveau dispose d’une mémoire (“stockée” dans les synapses) placée au plus proche du “centre de calcul” (que symbolisent les neurones) », explique le chercheur Damien Querlioz dans un dossier du CNRS. En imitant ce fonctionnement, les puces neuromorphiques consomment beaucoup moins d’énergie que les autres neurones artificiels.

Un autre champ d’exploration dans le hardware de l’intelligence artificielle est l’ordinateur quantique, un nouveau type d’ordinateur aux performances exceptionnelles. Pourquoi dès lors ne pas concentrer toute sa R&D sur l’informatique quantique, si elle est si remarquable ? Parce qu’elle sera dédiée à des tâches spécifiques, elle ne remplacera pas tous les ordinateurs traditionnels, répond Xavier Vasques. Et puis avant que l’informatique quantique ne se démocratise, il faut répondre aux problématiques du quotidien, commente Nicolas Coudert, IoT Business Lead chez Microsoft.

L’une de ces problématiques, c’est la capacité à exécuter le modèle entraîné, la phase d’inférence, là où c’est le plus pertinent. Dans une voiture autonome, vous n’allez pas attendre que les données enregistrées par les capteurs soient envoyées vers le data center, analysées là-bas, puis que la réponse soit transmise à la voiture pour que celle-ci se mette à freiner quand une personne déboule devant elle. Il y a suffisamment de place dans un véhicule pour caser un ordinateur qui traite les tâches en local — c’est ce qui est appelé dans l’industrie l’edge computing, le traitement des données à la périphérie, en opposition au cloud computing, centralisé.

Mais les contraintes de place sont parfois extrêmes. Il n’est pas possible de faire entrer une carte graphique ni même une puce de la taille de l’Apple A12 dans tous les objets que l’on veut rendre intelligents. La start-up toulonnaise Cartesiam entend répondre à ce cas de figure avec un framework capable d’apporter l’intelligence artificielle, tant la phase d’apprentissage que celle de l’inférence, dans des objets munis de simples microcontrôleurs très peu puissants.

L’exemple donné par Joël Rubino, PDG de Cartesiam, est celui de Bob, une sorte de stéthoscope de machines industrielles qui détecte et qualifie les anomalies en écoutant les vibrations. « Tout ça, c’est réalisé dans le capteur, sans connexion au cloud », déclare-t-il, en soulignant que c’est un avantage pour la sécurité, car les données ne sortent pas de l’entreprise.

Faut-il pour autant couper toute connexion au cloud ? Non, car en remontant l’info, une analyse de l’ensemble du parc devient réalisable. « La stratégie edge est complémentaire de celle du cloud », résume Joël Rubino.

Dit autrement, l’intelligence artificielle est une intelligence collective, qui allie le data center au microcontrôleur, l’ordinateur quantique à la puce la plus basique, le big data à la donnée individuelle.