À peine plus d’un an après la présentation des deux premiers modèles de la famille, Google présente Gemma 3, la nouvelle génération de modèles « ouverts et légers » construits sur les fondations de Gemini 2. Avec quatre modèles comptant entre 1 et 27 milliards de paramètres, Google veut concurrencer DeepSeek sur les appareils mobiles tout en fournissant des performances comparables à celles de Gemini sur les stations de travail.

Conçue comme une fenêtre permettant d’apercevoir les rouages de Gemini sans dévoiler ses secrets, Gemma est une famille de modèles open source que les développeurs peuvent utiliser comme bon leur semble. Avec 2 et 7 milliards de paramètres, les deux premiers modèles fournissaient des performances comparables aux plus petites versions de Llama 2 et de Mistral, mais demandaient l’emploi de stations puissantes, voire du cloud de Google.

Gemma 3 vise à résoudre cet écueil en proposant quatre modèles du plus économe au plus performant. Les modèles à 4, 12 et 27 milliards de paramètres partagent des caractéristiques similaires : une fenêtre de contexte de 128 000 tokens qui leur permet d’avaler un roman tout entier, un encodeur visuel à 417 millions de paramètres qui leur permet d’analyser des images et de courtes vidéos, ainsi qu’une intégration directe à ShieldGemma 2 pour vérifier la conformité des images à une politique prédéfinie.

Les performances de Gemma3-4B sont comparables à celles de Gemma2-27B, tandis que celles de Gemma3-27B rivalisent avec celles de Gemini-1.5. Les modèles peuvent être utilisés pour créer des « agents », ces applications qui peuvent réaliser des actions à votre place, ou adaptés à des besoins ou des langues spécifiques, comme le montrent les projets proposés dans le Gemmaverse.

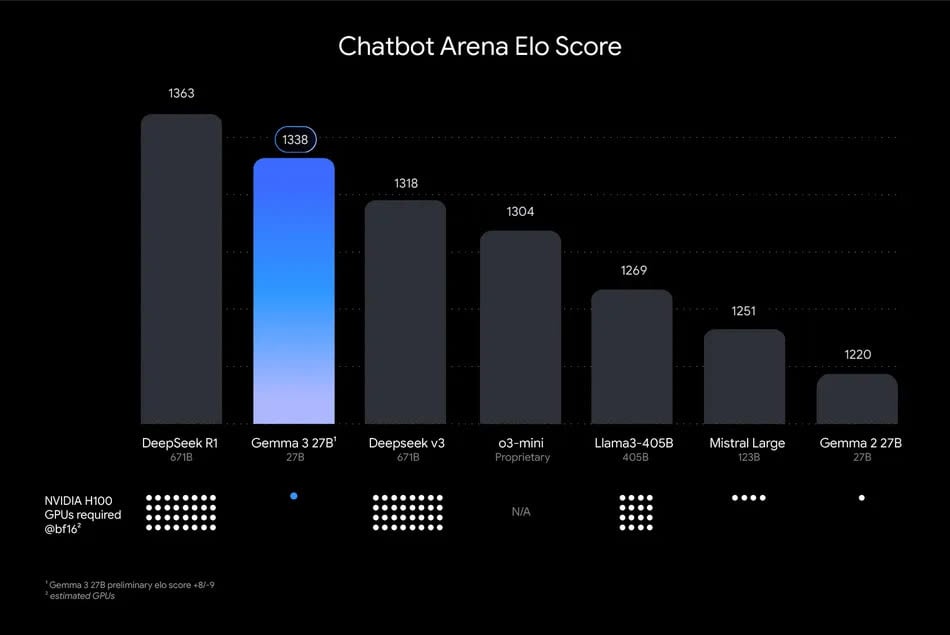

Mais la principale nouveauté vient du modèle Gemma3-1B, dont la fenêtre de contexte est réduite à 32 000 tokens et qui fait l’impasse sur l’encodeur visuel, mais qui peut tourner sur un simple téléphone. Google assure que Gemma3-27B peut être utilisé avec une seule carte Nvidia H1000, soit trente-deux fois moins que DeepSeek R1 et DeepSeek V3 pour des performances comparables. La firme de Mountain View offre des crédits sur sa plateforme de calcul pour inciter les développeurs et les chercheurs à essayer sa nouvelle famille de modèles.

DeepSeek, la tempête boursière dans un verre de ChatGPT 4o

Comment faire tourner DeepSeek-R1 (ou un autre LLM) sur votre Mac