L'épatant Whisper, le modèle de reconnaissance de langage d’OpenAI qui transcrit fidèlement l'audio en texte, devient encore un peu plus épatant grâce à une optimisation technique significative. whisper.cpp, son populaire portage en C/C++, a depuis peu gagné une prise en charge complète du GPU sur l'architecture Apple Silicon. À la clé, une amélioration drastique des performances.

Le créateur de l'application MacWhisper, qui vient d'implémenter whisper.cpp 1.5, communique sur une durée de traitement divisée par deux ou trois. Nous avons fait un essai sur un MacBook Air M1 avec un épisode de notre podcast Sortie de veille d'une durée de 16 min 30 et le modèle Medium (lent mais avec une excellente reconnaissance) ainsi que la détection automatique de la langue.

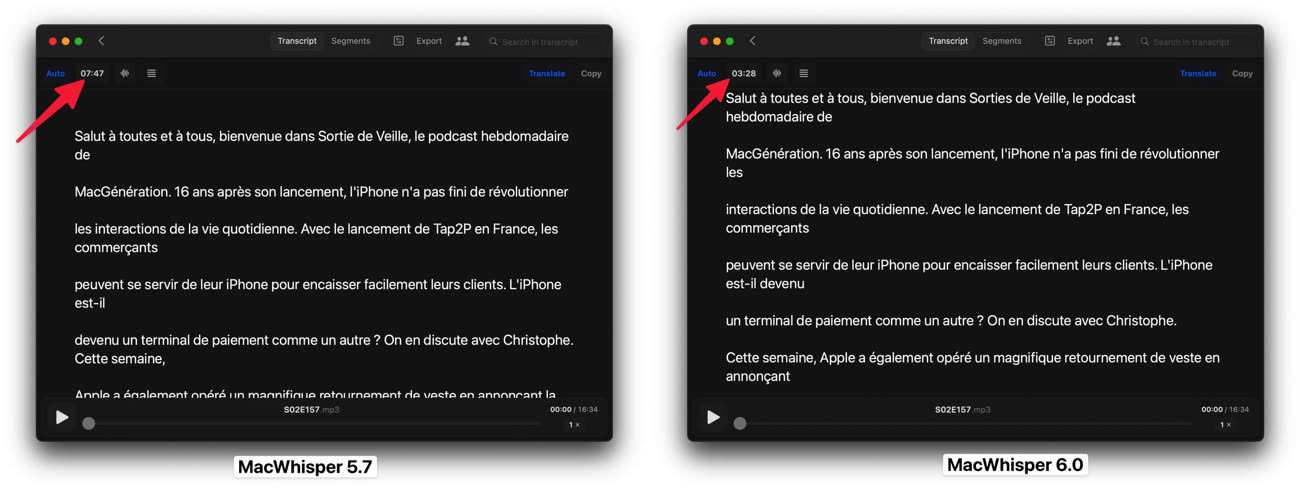

Avec la version 5.7 de MacWhisper qui s'appuie sur le CPU (le logiciel s'accapare 400 % du CPU) et le Neural Engine, la transcription complète a demandé 7 min 47. La même opération avec la version 6.0 de MacWhisper qui tire parti du GPU (le CPU n'est quasiment plus utilisé) ne prend plus que 3 min 28. La durée d'analyse est bien divisée par plus de deux, une sacrée différence qui peut inciter à utiliser un modèle plus volumineux (plus efficace en matière de reconnaissance, mais plus lent à faire tourner) qu'on ne le faisait jusqu'à présent.

Au passage, l'effort d'intégration de MacWhisper à macOS se poursuit avec la possibilité d'utiliser son clavier pour contrôler l'audio et la présence de l'app dans le menu multimédia de la barre des menus.

Hello Transcribe, une autre application qui se démarque par sa compatibilité iPhone/iPad en plus du Mac, a elle aussi été mise à jour récemment avec whisper.cpp 1.5. Son développeur annonce une amélioration des performances de 400 % avec un modèle large sur un Mac M1 Max et de 100 % avec un modèle médium sur un iPhone 14 Pro.