Google cherche depuis des années à réduire la taille des images sur le web. L’entreprise a lancé WebP il y a sept ans, un nouveau format d’images chargé de remplacer le JPG, mais qui n’a jamais totalement décollé. La faute notamment à une absence totale de prise en charge sur les appareils iOS et le JPG reste le format de référence pour les photos publiées sur internet. Fort de ce constat, le géant de la recherche essaie d’optimiser davantage les images dans ce format avec un nouvel algorithme de compression.

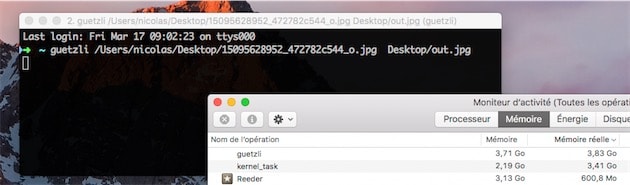

Nommé Guetzli (un terme suisse allemand qui désigne un biscuit), ce nouvel algorithme open-source est disponible dans une première version sur GitHub. Pour le moment, il ne s’agit que d’un outil en ligne de commande et il n’est pas optimisé du tout. Vous pouvez l’utiliser sur un Mac grâce au gestionnaire de paquets Homebrew (brew Install guetzli) et l’utiliser ensuite dans le terminal.

Après quelques essais, Guetzli fonctionne et il est sans doute prometteur, mais pas encore au point pour un usage courant. Ses concepteurs préviennent : l’optimisation exige beaucoup de mémoire vive, environ 100 Mo par mégapixel. Optimiser une photo prise avec un iPhone nécessitera environ 1,2 Go de mémoire vive, pour prendre un exemple. Par ailleurs, le processus est très long : il nous a fallu une dizaine de minutes pour optimiser certaines images.

Les développeurs de Google ou tous ceux qui le souhaitent (le projet étant libre) trouveront certainement des moyens d’optimiser l’outil. Guetzli promet des images jusqu’à 30 % plus légères que celles qui sont optimisées avec libjpeg, un optimiseur des années 1990 qui reste largement utilisé. Néanmoins, on a fait beaucoup mieux depuis et nous avons obtenu de nettement meilleurs résultats avec JPEGmini.

Ce nouveau-venu reste intéressant par son approche différente. Guetzli n’essaie pas seulement de réduire le poids des images, il s’efforce d’obtenir le fichier le plus petit possible, tout en restant le plus agréable à l’œil. Il exploite pour cela un outil de comparaison qui permet d’optimiser au mieux les choix à faire pour réduire la taille des fichiers. Concrètement, l’algorithme peut déterminer quel pixel est indispensable et quel pixel peut-être retiré, et il le fait avec l’objectif de garder quelque chose de plaisant à regarder à la fin.

Il reste encore du travail pour fournir une compression rapide et des fichiers encore mieux optimisés. Le travail va continuer sur GitHub et vous pouvez y participer si vous le souhaitez.

Source :