Le fondateur d'Oracle, Larry Ellison, a annoncé que la société dépense des milliards dans les puces de Nvidia, avec dans l'idée de développer des services d'IA équivalents à ceux d'OpenAI, à l'origine du célèbre ChatGPT.

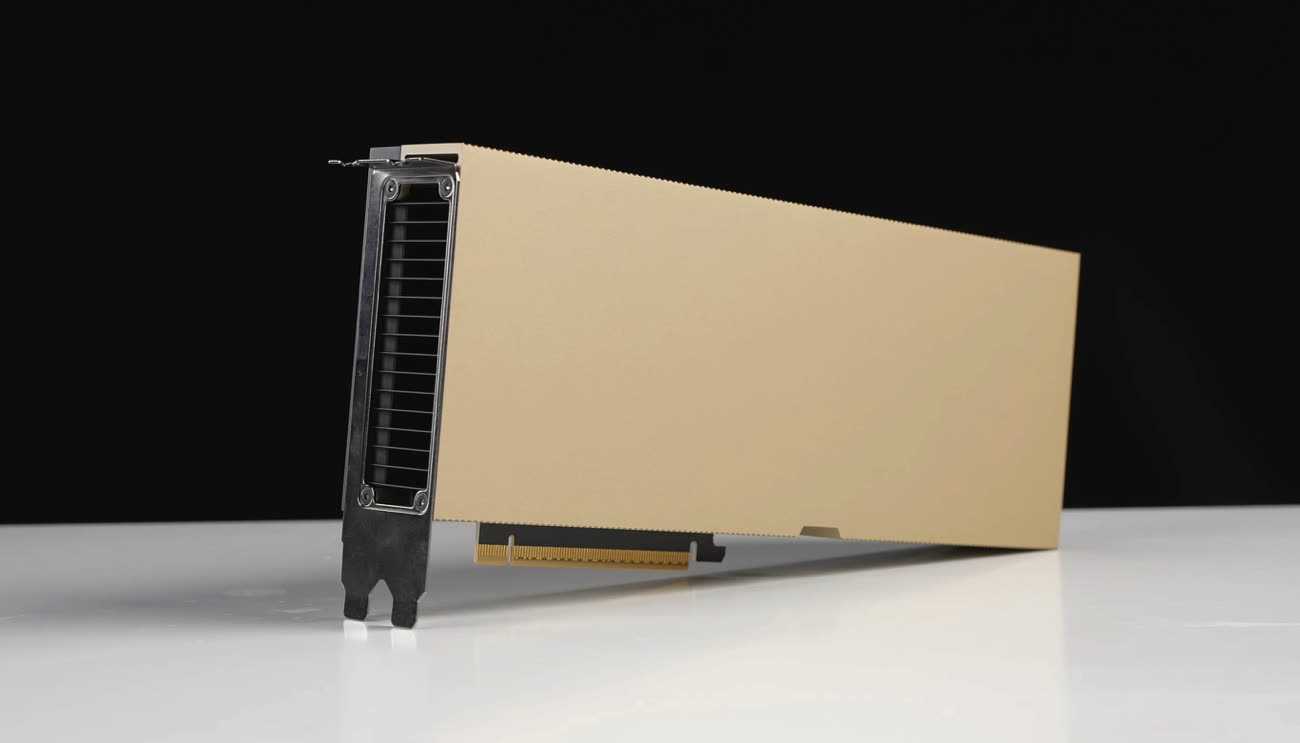

Comme Reuters l'explique, Oracle veut évidemment concurrencer ses deux rivaux principaux dans le monde des nuages1, Amazon Web Services et Microsoft. Point intéressant, la société ne se concentre pas uniquement sur les « GPU » de Nvidia — les cartes A100 et H100 employées pour les calculs IA s'éloignent de plus en plus de simples cartes graphiques — mais aussi des CPU de chez AMD (en x86) et Ampere. Ces derniers sont des puces compatibles ARM, comme celles d'Apple, et visent les serveurs qui nécessitent des centaines de cœurs.

Si le fait d'investir des milliards peut sembler énorme, il faut rappeler que les gros modèles d'IA exigent des quantités de données faramineuses lors de l'entraînement, et que les cartes dédiées à cet usage chez Nvidia sont assez onéreuses. Les cartes de la génération Ampere se négocient vers 10 000 € (40 Go) et 20 000 € (80 Go). Les H100 (Hopper), plus rapides, doublent la donne avec un prix moyen aux alentours de 40 000 €. Et pour bien comprendre les ambitions d'Oracle dans ce domaine, la société travaille avec Cohere, une start-up fondée par des anciens de Google qui propose des systèmes comprenant jusqu'à 16 000 cartes H100 (nous vous laissons faire le calcul).

-

Casimir est hors-jeu depuis de nombreuses années. ↩︎