Lors des commémorations du centenaire d'Alan Turing, l'Association of Computing Machinery a réuni une trentaine de récipiendaires du Turing Award, un prix annuel décerné par l'association aux plus grands contributeurs de l'informatique. Des allocutions de haute volée se sont tenues pour revenir sur l'héritage d'Alan Turing, parmi lesquelles on trouve celle du lauréat de 2003, Alan Kay, l'un des pionniers de l'informatique moderne, et auteur de nombre de principes qui ont influencé toute l'industrie.

La statue du Commandeur

L'ombre d'Alan Kay a toujours plané sur le parcours d'Apple. D'abord, parce qu'il fut l'un des architectes du Xerox PARC, où de nombreux concepts de l'informatique moderne furent développés (et incidemment repris à son compte par Steve Jobs après plusieurs visites, d'illustre mémoire) : l'interface graphique, la collaboration en réseau et le standard Ethernet, l'impression laser, la programmation orientée objet, etc. Ensuite, parce qu'il fut un membre émérite de l'Advanced Technology Group, le pôle en charge de la recherche et du développement chez Apple (et où naquirent QuickTime, HyperCard, AppleScript, les Data Detectors, et bien d'autres).

Mais au-delà des principes qu'il a mis au point, Alan Kay est également l'auteur de bien des citations que Jobs affectionnait et évoquait de manière récurrente. Lors de la présentation historique de l'iPhone, sans doute l'un des tout meilleurs keynote de feu Jobs, il a évoqué Alan Kay en ces termes :

« L'un des pionniers de notre industrie, Alan Kay, nous a donné nombre de bons aphorismes au fil des ans. Je suis tombé sur l'un d'entre eux récemment qui explique la manière dont nous abordons les choses. Cela explique pourquoi nous faisons les choses de cette manière, parce que nous sommes des passionnés du logiciel.

Voici la citation : "Tous ceux qui prennent le logiciel vraiment au sérieux devraient fabriquer leur propre matériel."

Alan a dit cela voilà maintenant 30 ans, et c'est ce que nous pensons. »

Alan Kay était opportunément présent dans l'assistance, à l'invitation de Steve Jobs. À la fin de la présentation désormais mythique, Jobs était curieux d'avoir ses impressions. Alan Kay a relaté l'entretien :

« Lorsque le tout premier Mac est sorti, Newsweek m'a demandé ce que j'en pensais. J'ai répondu : eh bien, c'est le premier ordinateur personnel digne de critiques. Et donc à la fin de la présentation, Steve est venu me voir et a demandé : l'iPhone est-il digne de critiques ? Et j'ai répondu : faites-en un avec un écran de cinq pouces sur huit, et vous règnerez sur le monde. »

L'iPad n'était plus loin.

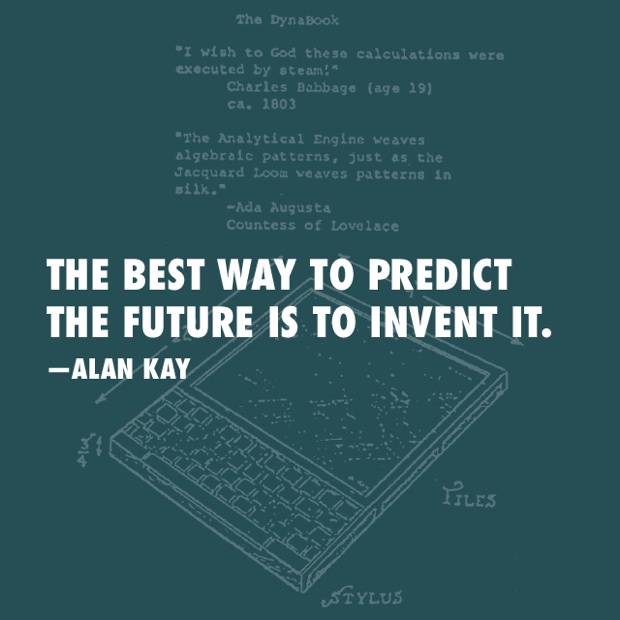

Il faut dire que parmi les hauts faits de Kay, on trouve notamment le concept du Dynabook, inventé en 1968, qui fait beaucoup penser à un iPad auquel on aurait greffé un clavier sous l'écran. (Alan Kay, assez prompt à se citer lui-même, dira d'ailleurs du Tablet-PC que c'est le "premier ordinateur similaire au Dynabook qui soit digne de critiques"). Si le Dynabook en resta au stade de concept pour ne jamais être fabriqué, on en ressentit l'influence depuis les premiers ordinateurs portables jusqu'à nos jours.

Mais revenons à la cérémonie donnée en l'honneur d'Alan Turing : Andrew Binstock, du site dédié au développement Dr Dobbs , assistait aux conférences et a profité de l'occasion pour interviewer Alan Kay. Aujourd'hui âgé de 72 ans, l'homme ne fait pas mentir son légendaire franc-parler : il ne manque toujours pas de ses proverbiales sentences et de ses jugements lapidaires sur l'industrie en général. La conversation, telle que retranscrite par Binstock, semble quelque peu décousue, en dépit des efforts éditoriaux déjà réalisés pour la transcrire : le brillant esprit est toujours aussi vif et touche à tout. Si Apple n'est pas nommée une seule fois, on trouve en filigrane quelques thèmes qui lui sont chers cependant.

Binstock commence par revenir sur l'enfance d'Alan Kay, notamment pour éclaircir l'un des traits de sa légende : à l'âge d'entrer au CP, celui-ci avait déjà lu une centaine de livres et s'était rapidement aperçu que les instituteurs lui mentaient régulièrement. Alan Kay confirme l'anecdote, et ajoute que cet embryon d'esprit critique précoce lui a rendu la conformation au moule de l'école quelque peu délicate. L'anecdote est plus lourde de conséquences qu'il n'y paraît, car tout au long de sa carrière, jusqu'à nos jours, Alan Kay s'est particulièrement intéressé à l'éducation. Mais c'est surtout le traumatisme des images du camp de Buchenwald qui le motivera plus tard à s'intéresser à l'éducation, non pas tant par désir d'aider les enfants, mais plutôt d'en faire de meilleurs adultes à l'avenir.

Des louanges… aux critiques

Alan Kay s'emploie consciencieusement à rendre à César ce qui lui appartient, en citant nombre de ses collègues émérites et sur leur propre empreinte dans l'industrie. Il évoque notamment les avancées apportées par nombre d'Européens : les Britanniques William Newman, Christopher Strachey, Peter Landin, exilés aux USA suite à la crise du début des années 60, ont chacun contribué aux avancées américaines (William Newman a également fait partie du Xerox PARC). Kay évoque également les Français comme Patrick Baudelaire qui contribua à l'élaboration de polices de caractère vectorielles au PARC ou Henri Gouraud qui mit au point l'algorithme d'ombrage 3D qui porte son nom.

Alan Kay souligne également les mérites de Vinton Cerf, l'un des "pères" de TCP/IP et lauréat du Turing Award en 2004 : « C'est un type singulier. Pas seulement pour sa cervelle. C'est l'un des meilleurs chefs d'orchestre. Si vous deviez ne distinguer qu'une seule personne, étant donné qu'Internet fut un effort communautaire, celui qui a fait en sorte que cette communauté fonctionne, c'était Vint. Et c'était également le co-auteur de TCP/IP. Je l'adore. Je le connais depuis des années. Il dirige ses réunions de manière dure et organisée, mais il le fait si bien que tout le monde apprécie. »

Mais si Kay distribue les bons points, il n'en oublie pas pour autant de souligner les moins bons, révélant une nature quelque peu atrabilaire. L'informatique est pour lui comme la Pop Culture, toujours dans l'instant et le fébrilement, sans égard pour le passé ni pour une vision à long terme. Il souligne néanmoins que la Pop Culture a ses vertus et qu'elle peut s'avérer précieuse dans un dialogue avec la recherche plus fondamentale, mais il déplore que l'industrie ne se résume qu'à cette instantanéité : « La Pop Culture dédaigne l'Histoire. La Pop Culture est toute dévolue à l'identité et à l'esprit de participation. Elle n'a rien à voir avec la coopération, le passé ou l'avenir — tout est dans le présent. Je pense que c'est également vrai concernant ceux qui codent pour de l'argent. Ils n'ont aucune idée d'où vient leur culture — et Internet a été si bien conçu que beaucoup de gens le perçoivent comme une ressource naturelle, comme l'Océan Pacifique, plutôt que quelque chose fabriqué par la main de l'Homme. À quand remonte la dernière technologie d'une telle échelle qui ait été si dépourvue d'erreurs ? Le Web, en comparaison, n'est qu'une blague. Le Web a été fait par des amateurs. »

Il faut faire ici la distinction entre le Web et Internet (au sens strict le protocole de communication TCP/IP et par extension le réseau physique mondial) sur lequel sont bâtis d'autres protocoles d'échange de données, dont le HTTP qui incarne le Web. Et Kay de faire la démonstration de son propos tout en montant sur un de ses vieux chevaux de bataille : lorsque son interlocuteur lui fait valoir les succès comme Wikipedia, il lui rétorque que l'encyclopédie collaborative est bien en deçà de ce qu'elle aurait pu être : « Allez donc voir l'article sur le Logo, pouvez-vous y écrire et exécuter des programmes en Logo ? Y a-t-il des exemples ? Non. Les gens de Wikipedia n'y ont pas même pensé, en dépit du fait qu'ils sont sur ordinateur. C'est la raison pour laquelle je ne me sers jamais de PowerPoint. PowerPoint n'est qu'un simulacre de diapositives, et c'est pour moi une sorte de crime moral. C'est pourquoi je ne me contente pas seulement de faire des conférences dynamiques, mais je fais des choses avec lesquelles j'interagis en temps réel. Parce que c'est ce pour quoi l'ordinateur est fait. »

Kay n'a semble-t-il pas de mots assez durs pour les opportunités manquées par les navigateurs et les standards du web : « Allez sur n'importe quel blog, ou n'importe quel Wiki, et trouvez-en un qui soit WYSIWYG [ndt : What You See Is What You Get, un paradigme d'interface qui permet la manipulation directe des contenus tels qu'ils sortiront au final], comme dans Microsoft Word. Word est né en 1974. HyperCard en 1989. Trouvez-moi une seule page web qui soit seulement aussi bonne qu'HyperCard l'était [NDR : et pourtant le principe du Wiki fut inspiré par HyperCard, lire Une étincelle d'HyperCard dans les Wiki]. Le Web est né après, mais il a été créé par des personnes qui n'avaient pas d'imagination. Ils ne faisaient qu'essayer de satisfaire un besoin immédiat. Ce qui n'a rien de répréhensible en soi, excepté lorsque vous avez l'équivalent de la Révolution Industrielle à la puissance deux, vous finissez par mettre au point des standards de facto — dans le cas présent, de très mauvais standards de facto. »

Alan Kay évoque alors le concept d'objets dont il est le créateur : pour lui le navigateur aurait dû être une sorte de mini système d'exploitation, et non une simple application : « Le travail d'un système d'exploitation consiste à exécuter du code arbitraire de manière sécurisée, et non pas de vous dire quel genre de code vous pouvez exécuter. […] Une des façons de s'y atteler est la raison pour laquelle le WYSIWYG apparaît peu à peu dans le navigateur, c'est une meilleure manière d'interagir avec l'ordinateur que celle qu'ils ont d'abord utilisée. Donc bien évidemment ils vont le réinventer. J'aime à dire qu'autrefois, lorsque vous réinventiez la roue, vous pouviez vous faire taper sur les doigts pour ne pas avoir lu. Mais de nos jours les gens réinventent le pneu crevé. Je serais personnellement heureux qu'ils réinventent la roue, parce qu'au moins on avancerait. S'ils réinventaient ce qu'Engelbart a fait, nous serions bien plus avancés que nous ne le sommes. ». [NDR : Doug Engelbart était entre autres choses l'un des grands pionniers de l'interface graphique, lire notre article Une vieille histoire de rongeurs).

« Le défaut c'est probablement que le C oblige par nature à anticiper les choses, et non de les faire évoluer rétrospectivement. Comme ce n'est pas un système dynamique, la seule manière de lier des fonctionnalités est de le faire par avance. Vous vous souvenez du temps où il fallait démarrer l'ordinateur ? Il n'y a pas besoin de ça. On n'en a jamais eu besoin. Mais parce que c'est comme ça qu'il a été fait, vous finissez avec des méga-octets de fonctionnalités qui sont essentiellement intégrées que vous le vouliez ou non. Et désormais un millier d'appels système, alors que tout ce dont vous avez besoin c'est des objets qui migrent à travers le net, et lorsque vous avez besoin d'une ressource, elle vient à vous — pas de système d'exploitation. Nous n'utilisions pas de système d'exploitation au PARC. Nous n'avions pas d'applications non plus. Mais en réalité un échangeur d'objets. Le travail de l'interface utilisateur consistait à demander aux objets de s'afficher, et de faire un composite de ces vues avec d'autres. »

Si Steve Jobs s'empara du principe de l'interface graphique pour Apple (tout en finissant le travail encore très inachevé du PARC), il reprit plus tard le principe de la programmation orientée objet, également découvert dans le laboratoire de Palo Alto, lorsqu'il fonda NeXT. Son système d'exploitation était intégralement basé sur ce principe, comme autrefois Smalltalk le fut au Xerox PARC, avant de se retrouver chez Apple sous le nom de Mac OS X et iOS.

Toutefois aucun principe orienté objet actuel ne semble trouver grâce aux yeux d'Alan Kay : « Lorsque le C++ est sorti, ils ont tâché de satisfaire les programmeurs C, et ils ont mis au point un système qui n'avait ni queue ni tête. Et c'est également vrai pour la plupart des choses qu'on appelle systèmes orientés objet aujourd'hui. Aucun d'entre eux n'est un système orienté objet d'après ma définition. Les objets étaient des idées radicales, et ils ont été rétrogradés. »

Malgré ses reproches, Kay sait aussi chanter les louanges des personnes qu'il admire, comme son professeur d'informatique Bob Barton (concepteur des Burroughs B5000) qui lui enseigna à "désapprendre" pour mieux sortir des idées préconçues. « Il est en haut de ma liste des gens qui auraient du recevoir un Turing Award mais qui n'en ont jamais eu. Cette récompense est accordée par l'Association for Computing Machinery, ce qui est ridicule, mais elle représente les partis-pris académiques et informatiques développés par l'ACM. Ça n'a pas toujours été le cas. Barton était probablement la première personne à la mériter de son vivant. Il est mort l'an dernier, donc ça n'arrivera pas à moins qu'ils se mettent à en donner à titre posthume. C'est le même problème que les religions chrétiennes ont pour envoyer Socrate au paradis. Vous ne pouvez pas aller au paradis tant que vous n'avez pas été baptisé. S'il y a bien quelqu'un qui mérite d'aller au paradis, c'est Socrate, c'est donc un énorme problème. Il n'y a guère que les mormons qui ont résolu ce problème — et c'est ce qu'ils ont fait : ils ont baptisé Socrate par procuration. »

Les pionniers de l'informatique, pour ceux qui sont encore de ce monde, sont devenus pour la plupart de vieux messieurs. On ne pourra mesurer les avancées de l'industrie qu'à l'aune de leurs exploits. Ne serait-ce que pour cette leçon d'Histoire, et peut-être résoudre la problématique de la Pop Culture dont Kay se lamente, sans doute est-il important de leur prêter l'oreille, avant que leurs voix ne s'éteignent définitivement.