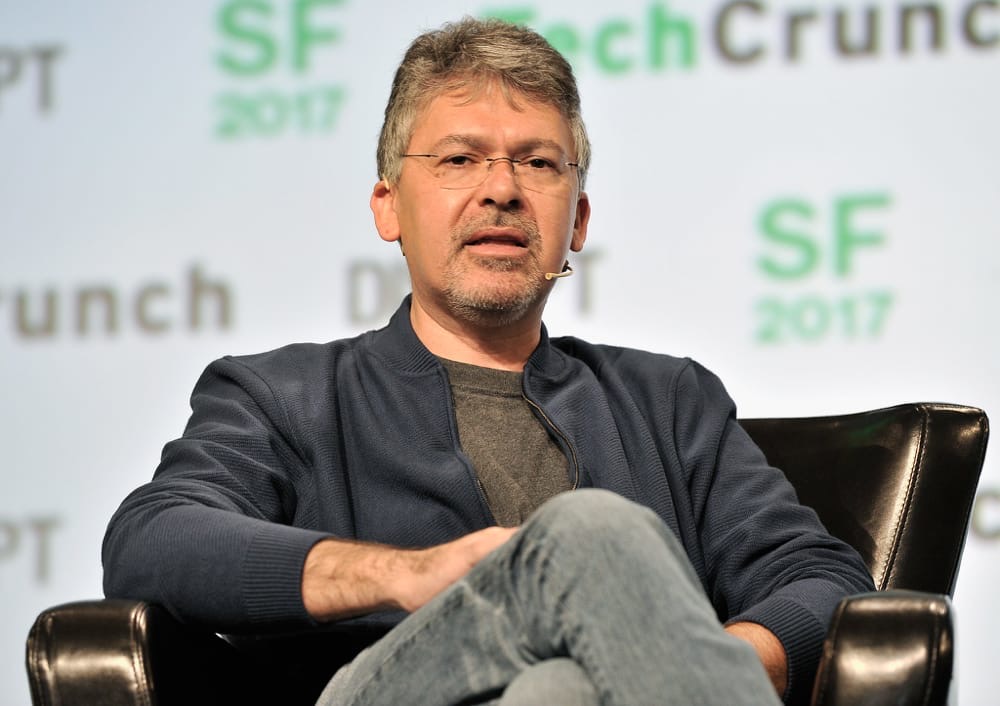

Quand John Giannandrea, transfuge de Google, a commencé à travailler chez Apple — c’était au printemps 2018 —, il a été surpris de constater qu’aucune technologie d’apprentissage automatique n’était utilisée pour le Pencil de l’iPad. « Où est l’équipe AI qui s’occupe de la reconnaissance de l’écriture », a-t-il demandé à l’époque. Il n’y en avait pas.

Cela a bien changé depuis : ces technologies permettent à iPadOS 14 d’exploiter encore mieux l’Apple Pencil, notamment la fonction Scribble qui infuse partout sur l’iPad (lire : L’Apple Pencil va devenir incontournable avec iPadOS 14). Celui qui est devenu vice-président d’Apple en charge de la stratégie intelligence artificielle a injecté de l’apprentissage automatique partout chez Apple, comme il l’explique dans un long article d’ArsTechnica en compagnie de Bob Borchers, vice-président marketing produit.

« Je pense honnêtement qu’il n’y a aucun coin d’iOS ou de ‘l’expérience Apple’ qui ne seront pas transformés par l’apprentissage automatique dans les prochaines années », assure-t-il. Giannandrea cherche à mettre un peu d’intelligence artificielle dans le plus grand nombre possible de fonctions et d’appareils, afin que ces « expériences » puissent être utilisées par le plus grand nombre.

C’est quelque chose qu’il ne pouvait pas faire chez son ancien employeur : « Google est une entreprise formidable, et il y a quelques grands technologistes qui y travaillent, mais fondamentalement, leur modèle économique est différent et ils ne sont pas spécialement connus pour fournir [comprendre : sur leurs appareils, NDLR] une “expérience utilisateur” à l’usage de centaines de millions de gens ».

L’apprentissage automatique permet de déterminer les faux touchés de l’utilisateur sur l’iPad (la paume de la main sur l’écran quand il utilise un Pencil). Ces techniques sont aussi à l’œuvre pour optimiser l’usage de la batterie en fonction de l’usage de la machine ; pour suggérer des applications ; pour les apps de réalité augmentée ; pour créer des souvenirs dans Photos ; pour le mode Portrait ; pour les prédictions du clavier virtuel…

Les fonctions de traduction dans Safari et dans la nouvelle application Traduire, ainsi que les fonctions autour de la santé (suivi du sommeil, lavage des mains) exploitent toutes l’intelligence artificielle développée par Apple. « Il y a de moins en moins d’endroits dans iOS où nous n’utilisons pas d’apprentissage automatique ».

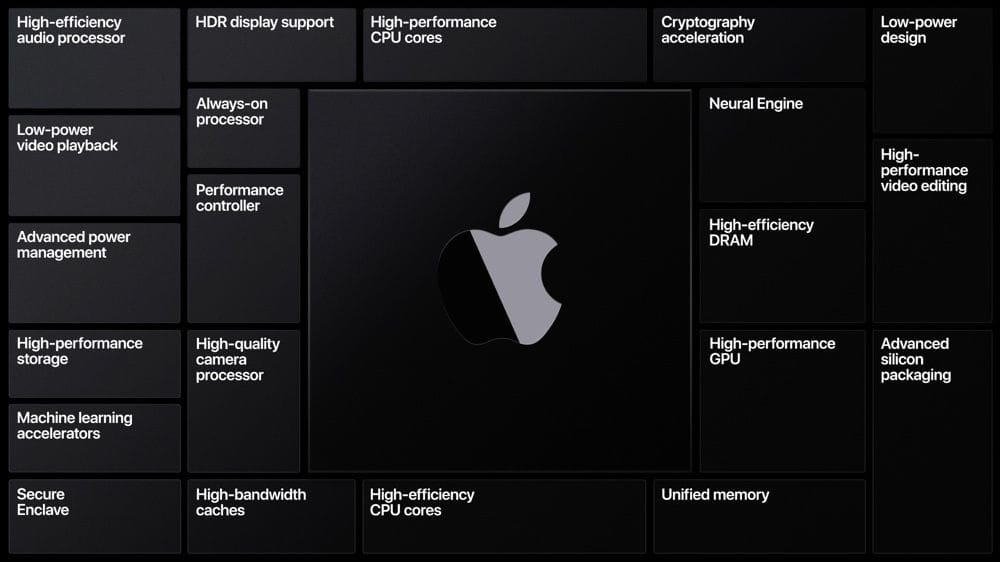

Google et d’autres s’appuient beaucoup sur les capacités de calcul de leurs serveurs distants, ce qui implique un transfert important de données. Apple a fait le choix inverse : un maximum de traitement des données en local, à même l’appareil, grâce à la puce Apple Neural Engine (ANE) et/ou au GPU « maison ». Utiliser l’un ou l’autre dépend de Core ML, dont le travail de triage est de décider si telles données doivent être moulinées par l’un ou l’autre des composants développés en interne.

On peut avoir l’impression que le traitement des données sur des serveurs peut donner des résultats plus précis, mais « en fait, c’est techniquement faux », s’insurge John Giannandrea. « C’est mieux d’exploiter le modèle au plus près des données, plutôt que de transférer les données ailleurs », explique-t-il. « Que ce soit pour des données de localisation en fonction de ce que vous faites, ou des relevés d’exercices sportifs (…), c’est mieux qu’elles soient proches de la source des données, et cela préserve aussi la confidentialité ».

Plaidoyer pro domo pour le traitement en local

Le vice-président avance deux arguments qui favorisent le traitement des données en local. Le premier est technique : « Si vous envoyez des données dans un data center, c’est compliqué d’avoir [la latence la plus faible possible] ». Certaines applications ne sont vraiment utiles que si elles sont en mesure de mouliner très rapidement les données, par exemple celles qui ont besoin d’identifier où sont les jambes et les bras de l’utilisateur dans l’espace, ou encore pour déterminer les mouvements d’une personne.

Autre exemple plus parlant : « vous prenez une photo, et juste avant d’appuyer sur le bouton, le capteur photo voit tout ce qui se passe en temps réel. Ce sont des informations qui peuvent vous aider à décider quand prendre une photo », illustre Giannandrea. Mais voilà, si cette décision dépend d’un serveur, il faut au préalable lui transférer chaque image captée par l’appareil photo. « Ça n’a pas beaucoup de sens, pas vrai ? Il y a beaucoup d’expériences qui sont bien meilleures quand elles sont calculées sur l’appareil en lui-même ».

Le deuxième atout du traitement en local a déjà été évoqué, c’est la confidentialité des données. Le dirigeant donne l’exemple d’un utilisateur qui veut écouter les messages laissés par son ami Bob. La voix de synthèse est générée par l’appareil, avec des calculs assurés par l’ANE. « Nous ne voyons jamais le contenu du message de Bob parce que c’est votre téléphone qui le lit, ce ne sont pas les serveurs. Donc, les messages ne transitent pas par les serveurs ».

Tout cela est bel et bon, mais même si le VP dit le contraire, force est de constater que les traitements sur des serveurs distants donnent souvent des résultats plus pertinents qu’en local. Apple fait le choix du calcul sur l’appareil quand le constructeur est sûr de faire aussi bien ou mieux que depuis un serveur, explique Giannandrea. Apple développe le Private Federated Learning qui, en substance, exploite les données en local tout en centralisant anonymement les améliorations apportées aux calculs (lire : Core ML : l'apprentissage automatique au cœur des produits d'Apple).

La conception de la puce neuronale est « évolutive » : elle est plus grande sur l’iPad que sur l’iPhone, qui est elle-même plus imposante que celle de l’Apple Watch. En revanche, l’API Core ML est la même pour Apple et pour les apps tierces, assure-t-il encore.

La Pomme cherche à traiter un maximum de données sur les appareils, mais il existe des cas où ce n’est pas possible, « un très petit pourcentage qui peut être utilisé pour entraîner le modèle ». Ce qui n’a d’ailleurs pas été sans controverse, comme on l’a vu l’été dernier où beaucoup ont découvert que des oreilles humaines écoutaient des bouts de conversation Siri. Depuis, Apple a mis en place des réglages supplémentaires pour participer ou pas à la collecte de données par des tiers.

Ces travaux sur l’intelligence artificielle vont désormais profiter aux Mac, par l’intermédiaire des puces Apple Silicon. Elles vont bien sûr intégrer une ANE, ce qui va ouvrir de nouvelles perspectives pour les ordinateurs « traditionnels » du constructeur. Bien sûr, John Giannandrea n’a rien voulu annoncer, mais il a donné l’exemple intéressant d’un logiciel d’édition vidéo dans lequel il sera possible d’obtenir les images où apparaissent des objets spécifiques, comme « une pizza sur une table ».

C’est le genre d’« expériences » qui pourraient faire partie du quotidien des futurs utilisateurs de Mac Apple Silicon.