Apple a participé à une conférence NIPS, qui se tient jusqu’au 10 décembre à Barcelone. Il s’agissait de montrer patte blanche à la communauté des chercheurs spécialistes de l’intelligence artificielle — à cette occasion, le constructeur a confirmé que les forts en thème embauchés à Cupertino avaient la possibilité de publier leurs travaux.

Le site Quartz a obtenu quelques photos volées des diapositives diffusées durant la présentation de Russ Salakhutdinov, fraîchement embauché (en octobre) au poste de directeur de la recherche en intelligence artificielle. Ces images permettent de faire le point sur les travaux de recherche menés par Apple dans le domaine de l’IA et sans surprise, ils ont un impact direct et très concret sur les produits et les services de l’entreprise.

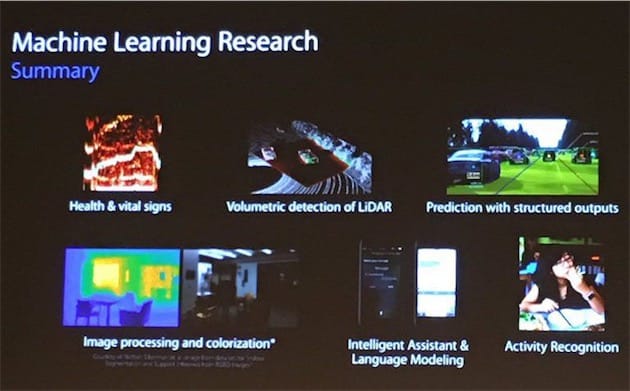

Apple planche sur des problèmes similaires à la concurrence, en particulier la reconnaissance et le traitement automatisé des images, la prédiction du comportement des utilisateurs et des événements se déroulant dans le monde réel, la modélisation du langage pour les assistants personnels, ou encore la manière de s’arranger face à l’incertitude d’un algorithme qui ne peut pas prendre une décision en toute confiance.

Parmi ces casse-tête, il est question de la conduite autonome et notamment des systèmes de détection des volumes LiDAR et de la prédiction des événements physiques. Deux des « briques » les plus importantes dans le monde des technologies liées à l’automobile sans chauffeur. Néanmoins, il n’a pas été fait mention d’une « voiture Apple » à proprement parler, même si le constructeur a tout récemment dit son intérêt dans le domaine (lire : Le plaidoyer d’Apple pour l’automobile autonome).

Une autre des diapositives d’Apple fait mention du développement de réseaux neuronaux de taille réduite (4,5 fois plus petits que les originaux), mais deux fois plus rapides. L’enjeu est de taille si on ose dire, notamment pour le traitement des photos. Au contraire de Google qui fait transiter toutes les images de l’utilisateur par ses serveurs, les photos restent sur l’iPhone ou l’iPad où elles sont moulinées pour être traitées de la manière la plus pertinente possible.

C’est le terminal qui doit par exemple identifier les visages et les lieux, sans avoir à passer par des serveurs. Pas besoin de connexion et de lourds transferts de données, et surtout ce mode de fonctionnement correspond à la volonté d’Apple de respecter la confidentialité de ses utilisateurs. Ce traitement est complexe, et il nécessite une grosse puissance de calcul.

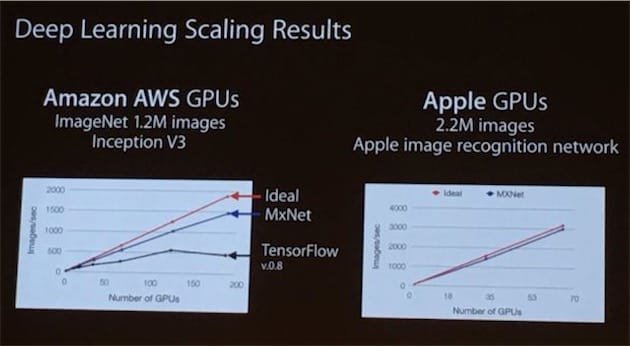

Le travail d’Apple est d’améliorer sans cesse la performance des algorithmes dont s’occupe le GPU — c’est ce composant en effet qui a la charge d’accélérer les calculs d’apprentissage automatique. Plusieurs constructeurs comme Microsoft ou Google ont développé des puces dédiées à ce fonctionnement, ce qui n’est pas —encore ? — le cas d’Apple qui s’appuie donc sur le GPU de ses appareils pour cette tâche.

Les efforts des équipes IA d’Apple semblent porter leurs fruits. D’après une des diapositives, l’algorithme de reconnaissance des images de la Pomme sait traiter deux fois plus de photos chaque seconde que chez Google : 3 000 i/s, contre 1 500 i/s pour le rival. Ce traitement mobilise environ un tiers du GPU.

On apprend aussi que les images utilisées par Apple pour « entraîner » ses réseaux neuronaux sont propriétaires, et que cette base de données est deux fois plus grande que celle d'ImageNet habituellement utilisée par la concurrence.

Avec la possibilité de publier leurs travaux, les chercheurs en IA d’Apple vont sans aucun doute nous donner de meilleures indications sur ce qu’Apple prépare dans ses labos.