Apple présente un modèle bien plus rapide que CLIP pour identifier le contenu des images

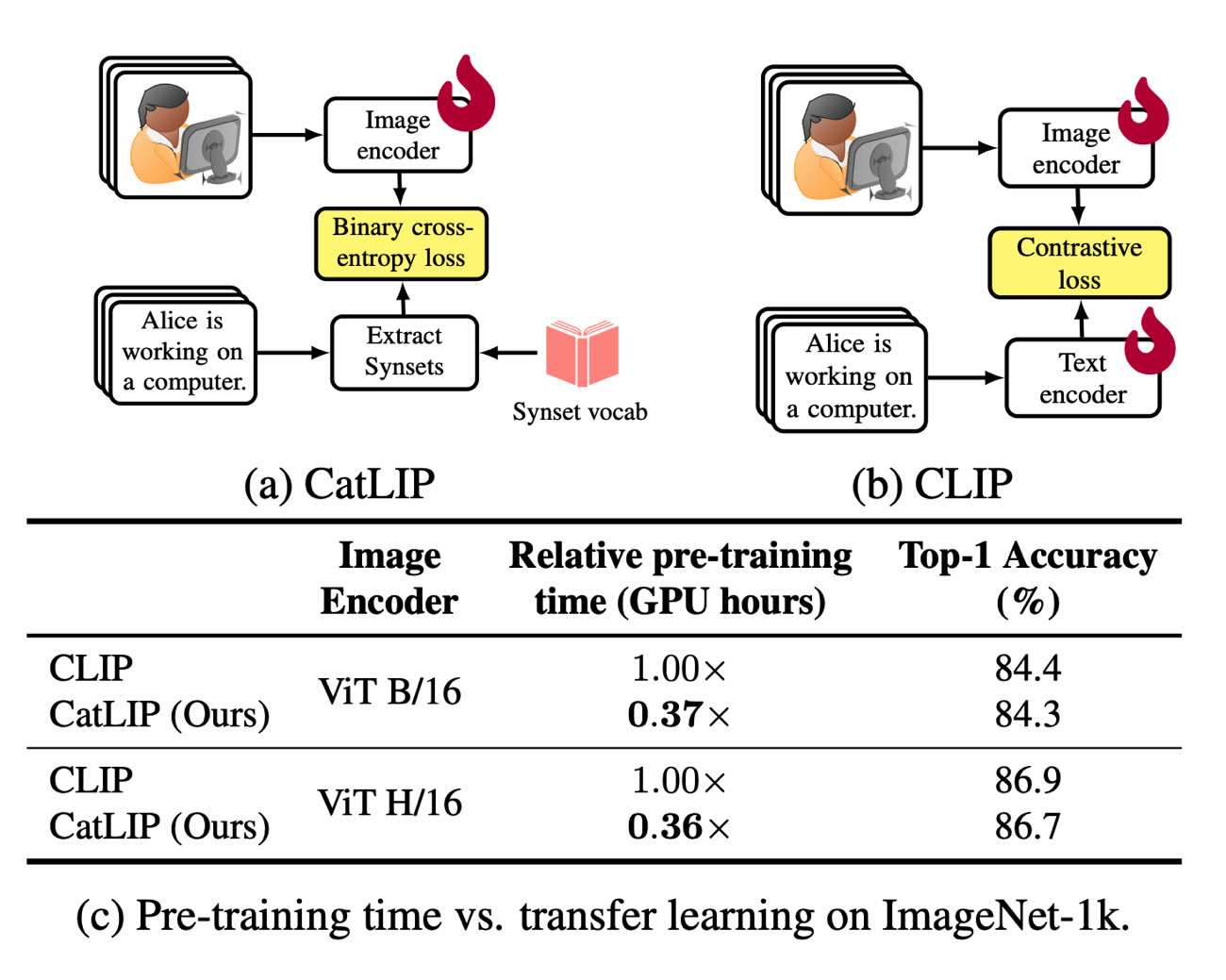

Apple continue de préparer le terrain pour une grosse vague d’IA, avec la publication de nouvelles recherches dans ce domaine. Cette fois, des chercheurs en la matière ont mis au point un modèle neuronal de classement d’images concurrent de CLIP d’OpenAI, un outil capable d’identifier ce que contient une photo en somme. CatLIP est annoncé comme étant nettement plus rapide : 2,7 fois plus que CLIP pour être précis, ce qui est intéressant car la vitesse d’exécution était justement un point faible du modèle d’OpenAI.

Grâce à ce gain, on pourrait envisager d’avoir la précision de CLIP à une vitesse suffisamment accrue pour offrir des résultats en temps réel ou pas loin. En comparaison, les outils qui reposent sur le modèle d’OpenAI ont besoin d’un temps d’analyse assez long en amont et de beaucoup de ressources pour y parvenir.

Queryable : le moteur de recherche intelligent qu'Apple devrait intégrer à Photos

Les résultats mis en avant par Apple suggèrent que la qualité de l’analyse est maintenue malgré la vitesse accrue des traitements. De là à penser que Photos pourrait intégrer CatLIP dans iOS 18 et macOS 15 ? On aura peut-être la réponse en juin…

Si ça fait ses preuves, ça va vraiment être une révolution pour ceux qui ne peuvent pas voir les images

@math65

Je crois que VoiceOver fait déjà la description des images

Effectivement il y a un gros coup à jouer au niveau de l'accessibilité car si le traitement est en temps réel on peut éventuellement penser à une sorte d'audio description et même pour la description d'image statique ça peut être très avantageux car actuellement le modèle met plusieurs secondes, je parle par expérience

Étant aveugle, j'adore vraiment ce type de fonction.

Je suis dyslexique, et utilise la fonction lire ce qu'il y a à l'écran (deux doigts vers le bas depuis le haut, il faut aller l'activer dans les params) J'ai remarqué que cette fonction marche de moins en moins bien, le pire sur macOS (sur les sites web j'active le mode lecture, et ensuite avec un raccourci clavier pour l'enclencher) c'est qu'elle s'arrête en cours de lecture... Je dois lui indiquer de poursuivre. Aussi elle interprète mal ce qu'il faut lire dans pas mal de situations...

Vive les technologies capables de donner plus d’autonomie à tous ceux et celles qui en manquent.

Pour la note d’humour, comme le chantaient les Stella, groupe belge :

“Ce n’est pas parce que tu es aveugle qu’il faut dépasser les borgnes….“

"Pour la note d’humour, comme le chantaient les Stella, groupe belge"

Un connaisseur 👏👏👏 Du coup je viens de me remettre un petit coup de Dark Side Of The Moule

@ codeX

> je viens de me remettre un petit coup de Dark Side Of The Moule

😆

Je vous conseille de faire un petit tour au Gallodrome à Lille, ils sont très sympas.

IN NORTH WE TRUST

LE HOUBLON FAIT LA FORCE

@Mike Mac

La vie c’est comme une tondeuse à gazon qui ne tond pas.

Son père buvait, sa mère buvait, son frère buvait, sa sœur buvait … alors quand il rentrait chez lui, y’avait plus rien à boire … que des bouteilles vides c’était comme ça tous les soirs ^^

😂

"Sttellla" deux "t" et trois "l"... non peut-être... 🙄

Les résultats d'Apple sont quand même moins bon que ceux d'OpenAI 🫢